Crawl Budget: Qué es y cómo lo puedes optimizar

¿Conoces qué es el Crawl Budget y cómo afecta al posicionamiento de tu proyecto web?

Es posible que ni te suene, o bien sí conozcas este término tan técnico a nivel SEO pero que no tengas muy claro en qué consiste ni si realmente le debes prestar atención o no.

Se trata de un aspecto clave para el posicionamiento de cualquier sitio web.

A lo largo de este post vamos a tratar de resolver todas tus dudas al respecto, y sobre todo, a ayudarte para mejorar el posicionamiento de tu web.

¿Qué es el Crawl Budget y por qué es tan importante para el posicionamiento de tu web?

En un internet con más de 1.700 millones de webs, y en aumento, cada vez se hace más complicado para buscadores como Google rastrear todas las páginas y contenidos que se publican a diario.

Aunque también crecen los recursos y tecnología que Google destina a estas tareas es evidente que no le es posible abarcar prácticamente en tiempo real todo el contenido que se publica.

Es decir, necesita filtrar para decidir qué webs analiza y cuales no.

Y precisamente para eso existe el Crawl Budget.

El Crawl Budget es el presupuesto de rastreo que Google asigna a cada web.

Ese presupuesto de rastreo define el período de tiempo y la frecuencia con que Google analiza las URLs y todo el contenido de tu web.

Para asignar ese presupuesto son dos los factores que más peso tienen:

- Popularidad: Aquellas páginas que son más populares en internet reciben más visitas para ser rastreadas y así actualizar el contenido indexado. La popularidad de una web está vinculada con la autoridad de dominio.

- Antigüedad: Google trata de evitar que el contenido indexado quede obsoleto por lo que prioriza las URLs que publican más contenidos recientemente.

También te puede interesar: Nombre de dominio web ¿Qué es y cómo elegir el tuyo?

De ese rastreo se encargan los Crawlers ¿Qué son?

Un crawler es un bot encargado de rastrear la web aplicando el presupuesto de rastreo asignado para una determinada web.

Un bot de rastreo tras obtener una lista de URLs se encarga de visitar y analizar el contenido de cada una de esas URL. Al mismo tiempo se puede dar el caso que en ellas puede encontrar nuevas URLs que añade al listado.

En el caso de Google este crawler se llama Googlebot, aunque también estos bots son conocidos como arañas.

¿Qué importancia debo darle al Crawl Budget?

Un buen presupuesto de rastreo es importante puesto que incide de forma directa en que Google indexe más contenidos y más frecuentemente contenidos en nuestra web.

Como consecuencia de ello podemos deducir que vamos incrementar las posibilidades de posicionar más contenido.

Eso es tal que así, sin embargo, y pese a lo que muchas veces se ha pensado, el presupuesto de rastreo no es un factor tan relevante como en ocasiones se ha podido escuchar y leer.

*También te puede interesar: Tendencias SEO

Según la propia Google el propietario de un sitio web cualquiera no debería preocuparse de esto demasiado puesto que se trata de un proceso automatizado del que Google se encarga por completo.

Ahora bien, si tu web cuenta con una considerable cantidad de URLs y volumen de contenido sí que puede ser necesario tener más en cuenta el presupuesto de rastreo asignado.

Si este es tu caso ten en cuenta que un presupuesto de rastreo bajo te puede afectar:

- En un peor posicionamiento para aquellos contenidos realmente relevantes

- Indexaciones más tardías y posibilidad de que tu competencia se te adelante posicionando ciertos contenidos, incluso pudiendo ser copiados del tuyo

¿Puedo mejorar el presupuesto?

La respuesta directa es que sólo Google puede modificarlo, sin embargo sí podemos influir en cierta manera para que esa asignación sea más beneficiosa para nuestros intereses.

Se trata de llevar a cabo toda una serie de buenas prácticas por las que facilitar el trabajo de rastreo de Googlebot y también mejorar los factores de popularidad y antigüedad.

¿Cómo puedo conocer el presupuesto de rastreo para mi web?

Son varias las formas que tenemos de conocer el presupuesto asignado. Todas ellas están relacionadas con los logs obtenidos de las visitas que Googlebot ha hecho a nuestra web.

Compartimos contigo tres herramientas que nos muestran las visitas que han realizado las arañas de Google:

Uso de logs de servidor de tu hosting.

En nuestro hosting, dentro de cPanel tienes disponibles estos datos estadístico.

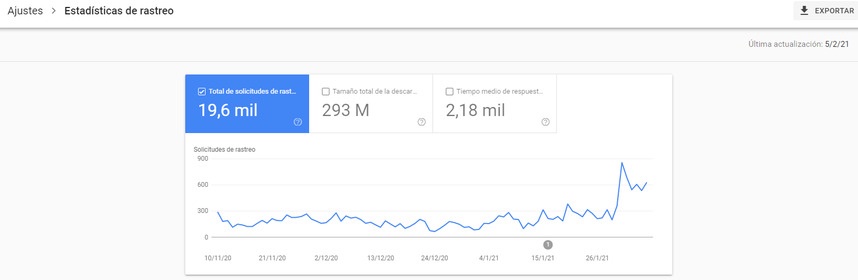

En Google Search Console.

En el apartado de Ajustes >Estadísticas de rastreo.

Uso de la herramienta [Screaming Frog Log File Analyser].

Una de las herramientas más completas que podemos usar.

¿Cómo puedo aumentar el presupuesto de rastreo de mi web?

Ahora que ya conocemos que es el Crawl Budget y cómo está siendo aplicado a nuestra web toca trabajar en mejorarlo y optimizarlo con una serie de acciones que podemos llevar a cabo.

A continuación te recomendamos 10 acciones que puedes aplicar y que van a favorecer el rastreo de por tu web.

1. Mejora la optimización WPO

Un aspecto clave de todo rastreo es el tiempo que un bot dedica a rastrear una web.

A más tiempo tarde en cargarse una URL menos tiempo puede dedicar la araña a rastrear otras URLs.

Descarga nuestra guía de optimización WPO aquí

Por tanto, una optimización de los tiempos de carga de tu web repercute en que Googlebot pueda rastrear más URLs.

2. Reduce el número de errores en tu web

Necesitas asegurarte de que en tu sitio web no existen errores, pues no sólo ya la experiencia de cualquier usuario que lo visite se va a ver perjudicada, también la de los crawlers de Google.

Debemos en todo momento mejorar también la experiencia y navegación de esos rastreadores.

Cuando un rastreador detecta una URL con un error, y por tanto no puede navegar por ella para comprobar su contenido, deja de indexarla.

De ese modo estamos perdiendo la posibilidad de indexar cierto contenido que nos puede resultar relevante.

Así pues, es importante revisar de forma periódica que no hay errores.

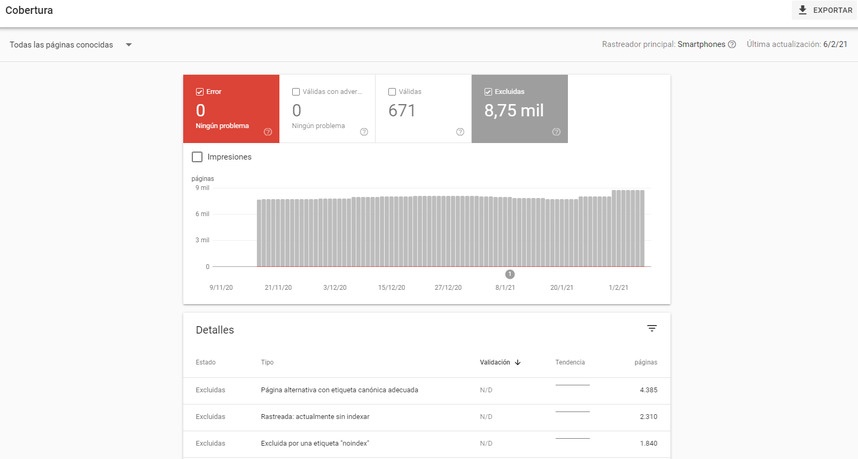

Para ello nos podemos valer de herramientas como Google Search Console en el apartado Cobertura.

3. Aumenta la autoridad de tu dominio

La autoridad de dominio es uno de los factores clave para Google a la hora de asignar un presupuesto.

La autoridad de dominio es un buen indicador de la popularidad de un sitio web.

Una estrategia de linkbuilding con enlaces de calidad que transmitan un buen linkjuice puede ser una muy buena opción para dar un empujón a la autoridad de tu dominio y mandar así señales positivas de popularidad a Google.

La autoridad de tu dominio la puedes medir por ejemplo con Moz.

4. Elimina todas las páginas de poco valor

A medida que un sitio web tiene más antigüedad e incorpora más contenidos es más posible que disponga de un mayor volumen de páginas y que de todas ellas algunas no tengan demasiado valor.

Los motivos pueden ser:

- Por estar desactualizadas

- Por no atender a intenciones de búsqueda

- Por no estar optimizadas a nivel SEO y no estar posicionadas

- Por disponer de contenido que ya no nos interesa mostrar

Esas páginas cuando alcanzan un gran volumen pueden, no sólo no aportan nada, si no que además pueden incidir en ocupar tiempo que Googlebot dedica a esas URLs y que quizás podría no estar dedicando a otras que sí son de valor y te interesa más que analice.

5. Define una arquitectura de página plana y con poca profundidad

Una arquitectura con pocos niveles facilita el rastreo de todas sus URLs y de su contenido.

De este modo Google puede entender mejor también la relación entre tus diferentes URLs y contenidos mejorando considerablemente la indexación de todo un sitio web.

Por supuesto esto no siempre es posible pero trata que su estructura sea lo más plana posible.

6. Actualiza los contenidos que has publicado

A Google le gustan los contenidos más recientes, es normal en cierta medida que así sea y tiene todo el sentido.

Un contenido publicado recientemente tiene más posibilidades de que atienda mejor a las intenciones de búsqueda del usuario.

El tiempo desde que el contenido ha sido publicado es uno de los factores clave para determinar el Crawl Budget asignado.

Por tanto, teniendo en cuenta este factor debemos tratar de actualizar todas las páginas de nuestra web de forma periódica en la medida en que nos sea posible.

Por supuesto existen páginas estáticas como la página de contacto en que no es necesario pero existen otras en que sí es relevante.

En webs con cierta antigüedad que tienen un blog puede ocurrir que su contenido quede desactualizado por completo.

Una buena forma de actualizar esos contenidos es reescribir esos posts o simplemente añadir ciertos cambios en su contenido.

A la hora de actualizar conviene despublicar ese post (convertir a borrador) y volver a publicar inmediatamente ( para evitar que pase el crawler y no la encuentre ) para así, además de cambiar a la fecha actual su publicación, que también los agregadores de noticias la detecten como nuevo post.

Lo mismo podemos hacer también con otras páginas.

Otra forma de mostrar a Google que una página se ha actualizado es añadiendo una sección con los últimos posts publicados en tu blog.

Esta es una práctica que puedes apreciar en muchas webs ¿verdad?

De esta forma páginas con contenido estático pasan a tener contenido dinámico.

De este modo Google identifica que hay contenido nuevo de manera habitual y la actualizará de forma periódica aumentando a su vez el presupuesto que dedica a su rastreo.

7. Define páginas «no index» y enlazado «no follow» en tu web

Seguro que hay páginas en tu web que no necesitan ni ser indexadas ni que requieren enlaces con seguimiento.

Sin embargo no puedes prescindir de ellas, como te recomendábamos con las páginas con contenidos de poco valor.

Estas páginas pueden ser las de avisos legales, cookies o incluso una landing page promocional.

Marcando estas páginas como etiquetas «no index» o enlaces «no follow» puedes ayudar a Googlebot a visitar aquellas URLs que más te convienen.

8. Crea un sitemap

Un sitemap, como su propio nombre indica es un mapa que incluye las páginas más relevantes que quieres que Googlebot visite.

Gracias a ofrecer un sitemap la araña de Google será más eficiente y rápida haciendo su trabajo.

9. Optimiza tu robots.txt

Un archivo Robots.txt permite bloquear el acceso a Google a determinadas partes de tu web.

Esto resulta beneficioso, pues nuevamente estamos acotando el contenido que queremos que los bots analicen ganando en eficiencia evitando gastar parte del presupuesto en recorrer zonas de la web no necesarias.

Aún así, ten en cuenta que se trata de un archivo que debemos generar con cuidado ya que podríamos restringir determinados accesos requeridos.

10. Reduce el número de redirecciones

Las redirecciones en sí mismas son una solución que en muchos casos resultan imprescindibles sin embargo abusar de ellas es perjudicial para el rastreo.

Un gran número de redirecciones incrementa el tiempo que el bot emplea en el rastreo de URLs.

Conclusiones

Como hemos visto a lo largo de este post disponer de un buen presupuesto de rastreo es es importante si perseguimos mejorar nuestro posicionamiento.

Ahora bien, conviene valorar bien hasta que punto tiene relevancia para nuestra web.

No tendrá el mismo impacto en webs con un gran volumen de URLs y contenido que en otras más pequeñas.

Ahora, con toda la información que te hemos ofrecido te toca a ti analizar si tu web requiere mejorar su crawl budget.